Een kunstmatige intelligentie kan op basis van hersenscans beelden genereren van plaatjes waar mensen naar kijken. Zulke systemen bestonden al, maar zijn extreem complex en energie-intensief. De nieuwe aanpak is veel eenvoudiger.

Het systeem is ontwikkeld op basis van een populaire kunstmatige intelligentie (AI) die tekst kan omzetten naar beeld. Door aanpassing kan deze AI nu beelden genereren op basis van hersensignalen, in plaats van tekst. Maar het systeem vereist nog wel uitgebreide training met grote en dure beeldvormingsapparatuur, dus echt praktisch is het nog niet.

De afgelopen tijd zijn meerdere onderzoeksgroepen erin geslaagd om beelden te genereren op basis van hersensignalen, maar zij maakten gebruik van energie-intensieve AI’s die fijne afstelling vereisen van miljoenen tot miljarden parameters.

Kunnen we ooit praten met Poekie?

Met behulp van AI slagen onderzoekers er steeds beter in dierengeluiden te ontcijferen. Kunnen we ooit echt met onze hond of kat babbelen?

Neurowetenschappers Shinji Nishimoto en Yu Takagi van de Universiteit van Osaka in Japan hebben nu een veel eenvoudigere aanpak ontwikkeld. Hiervoor gebruikten ze Stable Diffusion, een tekst-naar-beeld-generator die in augustus 2022 door het bedrijf Stability AI is uitgebracht. Hun methode, gepubliceerd op de preprint-website Biorxiv, omvat slechts duizenden in plaats van miljoenen parameters.

fMRI-gegevens

Normaal gesproken verandert Stable Diffusion een stuk tekst in een afbeelding door te beginnen met willekeurige visuele ruis, waaruit het programma afbeeldingen produceert die lijken op afbeeldingen met vergelijkbare tekstbijschriften in de trainingsgegevens.

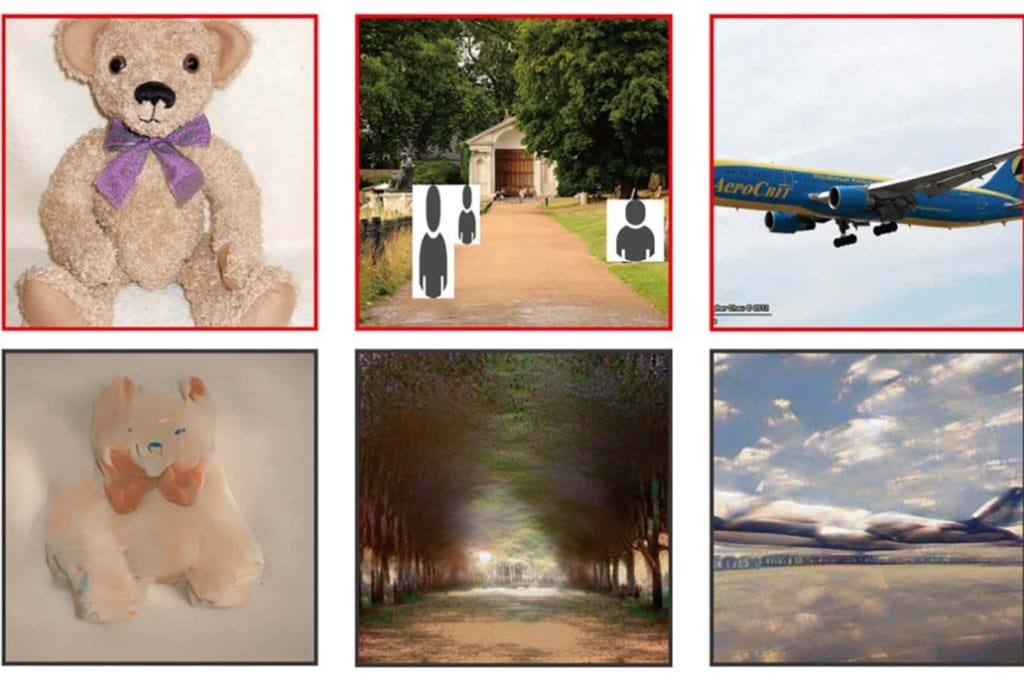

Nishimoto en Takagi bouwden twee nieuwe softwaremodellen die ze aansloten op Stable Diffusion, zodat die overweg kon met hersensignalen in plaats van tekst. Ze gebruikten daarvoor gegevens van vier mensen die hadden deelgenomen aan een onderzoek waarbij fMRI-scans van hun hersens werden gemaakt terwijl ze 10.000 verschillende afbeeldingen van landschappen, objecten en mensen bekeken.

Met behulp van ongeveer 90 procent van de scangegevens trainden ze een model om verbanden te leggen tussen fMRI-gegevens van een hersengebied dat visuele signalen verwerkt, de vroege visuele cortex, en de beelden die mensen bekeken.

80 procent nauwkeurigheid

Met dezelfde dataset trainden Nishimoto en Takagi een tweede model om verbanden te leggen tussen tekstbeschrijvingen van de afbeeldingen en fMRI-gegevens van een hersengebied dat de betekenis van afbeeldingen verwerkt, de ventrale visuele cortex.

Na hun training konden deze twee modellen, die op ieder individu moesten worden aangepast, hersenscangegevens vertalen naar een vorm die rechtstreeks in Stable Diffusion kon worden ingevoerd. Die slaagde er vervolgens in om zo’n duizend beelden die de mensen bekeken te reconstrueren met een nauwkeurigheid van ongeveer 80 procent, zonder getraind te zijn op die specifieke beelden. Dit nauwkeurigheidsniveau is vergelijkbaar met het niveau dat werd bereikt in een eerder onderzoek waarin dezelfde gegevens werden geanalyseerd met behulp van een omslachtigere aanpak.

‘Ik kon mijn ogen niet geloven. Ik beende naar het toilet, keek even in de spiegel, en keerde terug naar mijn bureau om de resultaten nóg eens te bekijken’, zegt Takagi.

Totaal niet praktisch

Een kanttekening is dat het onderzoek slechts op vier mensen is uitgevoerd, en gedachtenlezende AI’s bij sommige mensen beter werken dan bij andere, zegt Nishimoto.

Omdat de modellen moeten worden aangepast aan de hersenen van elk individu, vereist deze benadering bovendien langdurige hersenscansessies en enorme fMRI-machines, zegt computerwetenschapper Sikun Lin van de Universiteit van Californië in Santa Barbara. ‘Het is totaal niet praktisch voor dagelijks gebruik’, zegt ze.

In de toekomst zouden praktischer versies van deze aanpak mensen in staat kunnen stellen kunst te maken, afbeeldingen te veranderen of nieuwe elementen toe te voegen aan games, zegt Lin, met alleen hun verbeeldingskracht.